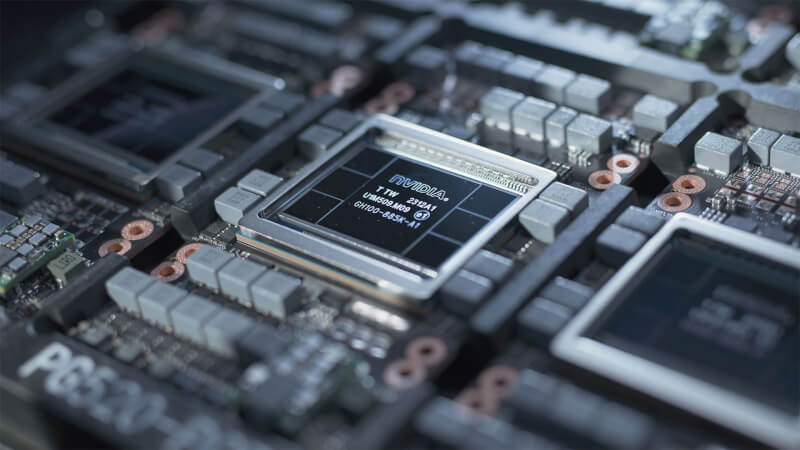

Musk: Grok 3 erfordert 100.000 NVIDIA H100 AI GPUs

Elon Musk, CEO von Tesla und Gründer von xAI, machte einige mutige Vorhersagen über die Entwicklung der Künstlichen Allgemeinen Intelligenz (AGI) und diskutierte die Herausforderungen, vor denen die KI-Branche steht. Er prognostiziert, dass AGI bereits im nächsten Jahr oder bis 2026 die menschliche Intelligenz übertreffen könnte, dass jedoch eine enorme Anzahl von Prozessoren zum Trainieren erforderlich sein wird, was wiederum riesige Mengen an Strom erfordert, berichtet Reuters.

Musks Projekt xAI trainiert derzeit die zweite Version seines großen Sprachmodells Grok und geht davon aus, dass die nächste Trainingsphase im Mai abgeschlossen wird. Für das Training des Modells Version 2 von Grok waren bis zu 20.000 Nvidia H100-GPUs erforderlich, und Musk geht davon aus, dass zukünftige Iterationen noch größere Ressourcen erfordern werden, wobei das Modell Grok 3 rund 100.000 Nvidia H100-Chips für das Training benötigt.

Fortschritte in der KI-Technologie werden laut Musk derzeit vor allem durch zwei Faktoren behindert: den Mangel an High-End-Prozessoren wie dem H100 von Nvidia, da es nicht einfach ist, schnell 100.000 davon zu bekommen, und die Verfügbarkeit von Strom.

Nvidias H100-GPU verbraucht bei voller Auslastung etwa 700 W, sodass 100.000 GPUs für KI- und HPC-Aufgaben bis zu 70 Megawatt Leistung verbrauchen können. Da diese GPUs für den Betrieb Server und Kühlung benötigen, kann man mit Sicherheit sagen, dass ein Rechenzentrum mit 100.000 Nvidia H100-Prozessoren rund 100 Megawatt Strom verbrauchen wird. Dies entspricht dem Stromverbrauch einer Kleinstadt.

Musk betonte, dass die Versorgung mit Rechen-GPUs bisher zwar eine erhebliche Hürde darstelle, die Stromversorgung jedoch in den nächsten ein bis zwei Jahren immer kritischer werde. Diese doppelte Einschränkung unterstreicht die Herausforderungen bei der Skalierung von KI-Technologien, um den wachsenden Rechenanforderungen gerecht zu werden.

Trotz der Herausforderungen werden Fortschritte in den Rechen- und Speicherarchitekturen in den kommenden Jahren das Training immer größerer Large Language Models (LLMs) ermöglichen. Nvidia stellte auf der GTC 2024 seinen Blackwell B200 vor, eine GPU-Architektur und -Plattform, die für die Skalierung auf LLMs mit Billionen von Parametern konzipiert ist. Dies wird eine entscheidende Rolle bei der Entwicklung von AGI spielen.

Aktuelle software

-

28 Augsoftware

-

07 Augsoftware

Musk verklagt OpenAI wegen Profitorientierung

-

07 Augsoftware

OpenAI verabschiedet sich von Top-Managern

-

01 Augsoftware

Google-KI-Systeme erzielen Durchbrüche in der Math

-

29 Julsoftware

AMD Amuse: Neues KI-Grafiktool für Ryzen und Radeo

-

26 Julsoftware

Logitech G kündigt MIXLINE an

-

28 Junsoftware

Chinesisches KI-Unternehmen bildet LLMs bei Huawei

-

26 Junsoftware

Die ChatGPT-Desktop-App für Mac ist fertig