Nvidia präsentiert KI-Chatbot für PCs

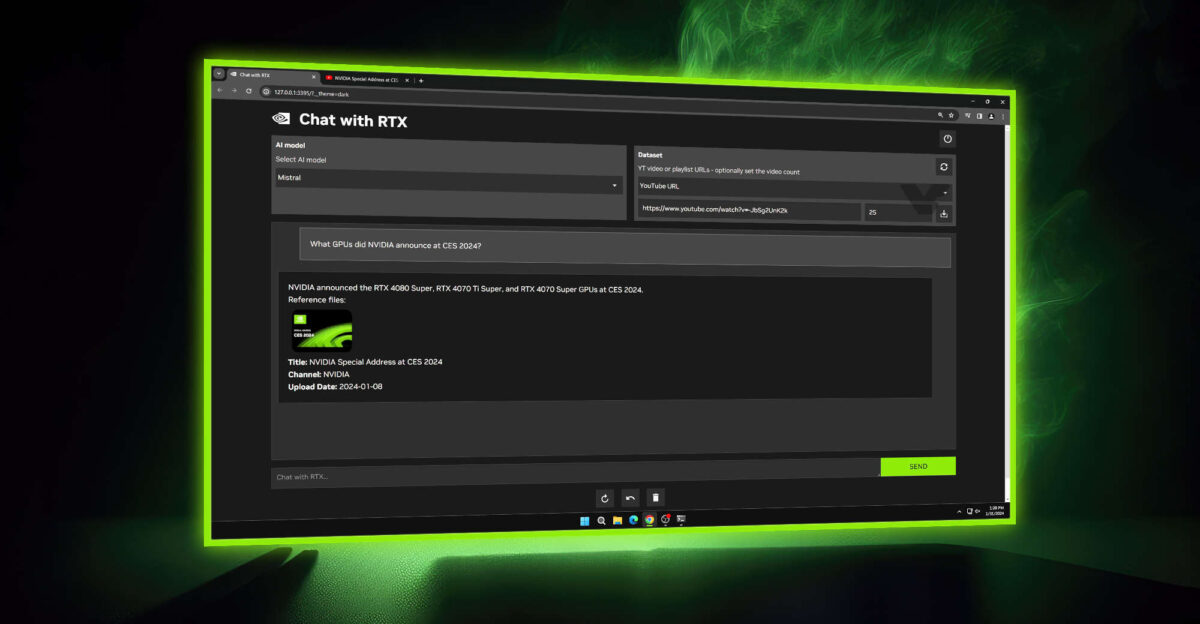

Am Dienstag veröffentlichte Nvidia eine Technologie-Demo mit dem Titel „Chat with RTX“. Die Software kann kostenlos heruntergeladen werden und ermöglicht Benutzern die Verwendung von Open-Source-KI-Store-Sprachmodellen – einschließlich Mistral oder Llama 2 von Meta Platforms – als Schnittstelle zu ihren Dateien und Dokumenten.

Nachdem ein Benutzer mit „Chat with RTX“ auf einen Ordner auf seinem Computer verweist, der TXT-, PDF- und Microsoft Word-Dokumente enthält, kann er dem Chatbot Fragen zu den in den Dateien enthaltenen Informationen stellen.

Das Nvidia-Team erklärte: „Da Chat with RTX lokal auf Windows RTX-Computern und -Workstations läuft, werden die Ergebnisse schnell präsentiert – und die Daten des Benutzers bleiben auf dem Gerät. Anstatt sich auf cloudbasierte LLM-Dienste zu verlassen, ermöglicht Chat with RTX den Benutzern die Verarbeitung.“ sensible Daten auf einem lokalen PC, ohne dass diese mit Dritten geteilt werden müssen oder eine Internetverbindung erforderlich ist.“

Laut Nvidia eignet sich die aktuelle Version der Software gut für Informationsabfragen, aber nicht so gut für Fragen, bei denen es um Überlegungen über den gesamten Dateidatensatz geht. Die Leistung des Chatbots verbessert sich auch bei einem bestimmten Thema, wenn er mehr Dateiinhalte zu diesem Thema erhält.

„Chat with RTX“ erfordert Windows 10 oder Windows 11 sowie eine Nvidia GeForce RTX 30 Series GPU oder 40 Series GPU mit mindestens 8 GB RAM.

Lesen Sie hier mehr bei Nvidia.

Aktuelle gadgets

-

20 Sepgadgets

-

10 Sepgadgets

Google Pixel Watch 3 (41 mm)

-

09 Sepgadgets

Elgato Lightstrip Pro

-

05 Sepgadgets

Nvidia-Aktien geschwächt durch mögliche Klage

-

03 Sepgadgets

Nvidia wird der zentrale Anbieter von KI sein

-

29 Auggadgets

Nvidia-Wachstum erreicht seinen Höhepunkt

-

28 Auggadgets

Nvidia-Gewinne könnten schwach sein

-

27 Auggadgets

Meta lehnt den Headset-Kampf ab

Die meisten gelesenen gadgets

Empfohlen von Tweak

-

15 Märgadgets

Busylight – was ist das?