Nvidia ist in Sachen KI immer noch stark, kann aber herausgefordert werden

Während Nvidia mit seinem vollständigen Produktökosystem und seiner Führungsrolle im Bereich KI einen erheblichen Wettbewerbsvorteil behält, könnten sich neue Dynamiken in diesem Markt und innovative KI-fokussierte Lösungen von Wettbewerbern auf die Bewertung und den Markt von Nvidia auswirken.

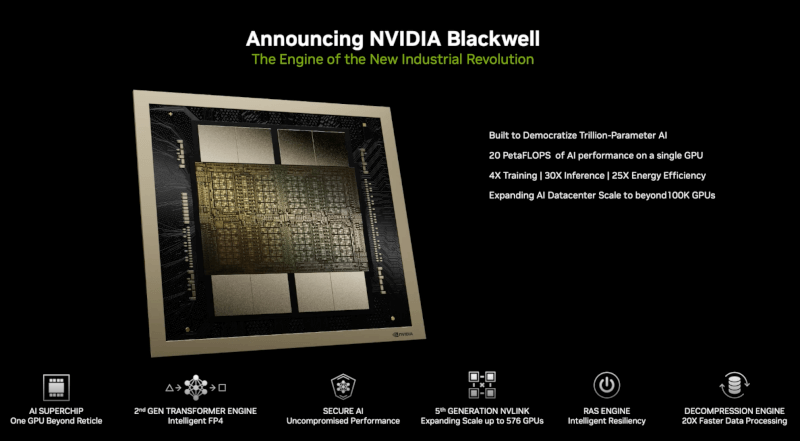

Der aktuelle „Burggraben“ von Nvidia ist sehr groß, aber es scheint, dass das Unternehmen eine erhebliche Schwäche hat, die aufmerksame Forscher und gut finanzierte Start-ups auszunutzen beginnen. Nvidia hat seine GPU und CPU ursprünglich für nicht-KI-spezifische Aufgaben entwickelt. Aber die Leistungsfähigkeit ihrer Berechnungen erwies sich als anwendbar auf Deep Learning und andere KI-Aufgaben und verschaffte Nvidia eine sehr starke Position, als die Nachfrage nach KI zu steigen begann.

Es ist jedoch wichtig zu beachten, dass Nvidia seine Infrastruktur auf der Grundlage von Berechnungen entwickelt hat, die nicht speziell auf KI ausgelegt sind. Das bedeutet jedoch nicht, dass Nvidia sich dessen nicht bewusst ist; Sie sind sich absolut sicher und werden alles tun, um Systeme und Infrastrukturen zu entwickeln, bei denen die KI im Mittelpunkt steht. Nvidia entwickelt beispielsweise weiterhin seine Tensor Cores weiter, bei denen es sich um spezialisierte Einheiten innerhalb der GPUs von Nvidia handelt, die KI-Arbeitslasten bewältigen. Google bietet auch Tensor Processing Units (TPUs) an, bei denen es sich um maßgeschneiderte Chips handelt, die mit Googles eigenem Framework für maschinelles Lernen arbeiten.

Allerdings besteht hier immer noch eine Chance für neuere Unternehmen, einen Teil des Marktes zu erobern, wenn sie Nvidia, Google und andere Technologiegiganten bei der Entwicklung von Chips herausfordern, die speziell für KI-Aufgaben entwickelt wurden. Der wichtigste Wettbewerbsvorteil dieser KI-spezifischen Chips ist die Effizienz bei KI-Aufgaben, was ein wichtiges Verkaufsargument darstellt, da Verbraucher schnellere Ergebnisse von KI-Systemen erwarten.

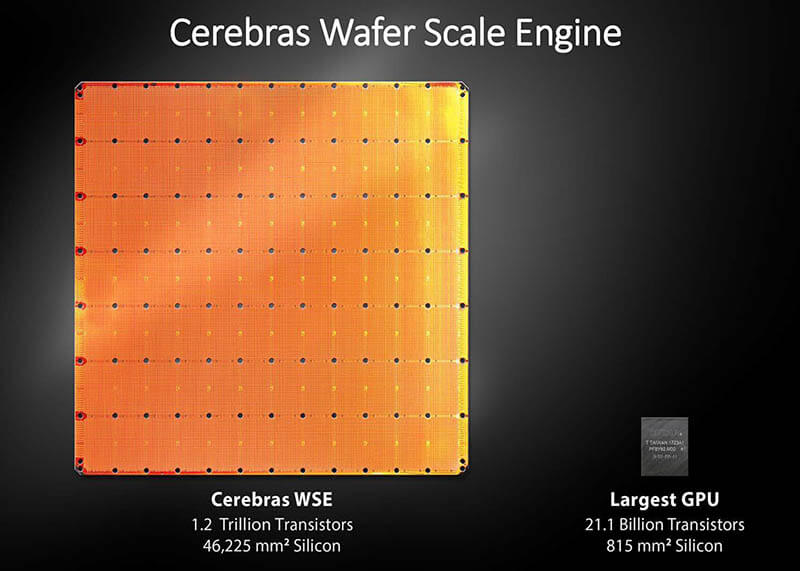

Konkurrenten wie Groq, Cerebras und SambaNova machen Nvidia in diesem Bereich bereits Konkurrenz. Groq bietet eine Tensor-Streaming-Prozessorarchitektur, die die Latenz reduziert und die Effizienz von KI-Berechnungen erhöht. Cerebras verfügt über einen riesigen KI-Chip namens Wafer Scale Engine, der schnelle und effiziente KI-Berechnungen durch minimale Datenübertragung ermöglicht. SambaNova bietet mit seinem DataScale-System, das auf KI-spezifischen Chips basiert, eine integrierte Hardware- und Softwarelösung.

Obwohl Nvidia nach wie vor der führende Akteur in der KI-Infrastruktur ist, könnten diese innovativen Konkurrenten die Dominanz des Unternehmens im KI-Chip-Design in Frage stellen. Es ist jedoch wichtig anzumerken, dass Nvidia nach wie vor ein außergewöhnliches Unternehmen mit einem starken strategischen Fokus ist, der ihnen bei der Bewältigung dieser Herausforderungen helfen wird.

Auch Nvidias CUDA verdient hier eine besondere Erwähnung, da es sich um eine Architektur handelt, die es einer Vielzahl von Kunden ermöglicht, Nvidias GPUs für allgemeine Verarbeitungszwecke zu nutzen. Dadurch kann Nvidia die Leistung seiner Hardware für verschiedene Zwecke nutzen. Während es auf dem KI-Markt Konkurrenz gibt, bleibt Nvidia führend im Bereich KI und seinen breiteren Anwendungen. Ihr Full-Stack-Ökosystem und die kontinuierlichen Innovationen bei der KI-Integration positionieren sie stark für die Zukunft.

Aktuelle prozessor - cpu

-

31 Oktprozessor - cpu

-

16 Sepprozessor - cpu

AMD Ryzen AI 7 PRO 360 entdeckt

-

04 Sepprozessor - cpu

Intel gewinnt großen KI-Chipkunden

-

04 Sepprozessor - cpu

Exklusiv von Intel hergestellte Ladenschubladen

-

29 Augprozessor - cpu

Großer Leistungsschub für Ryzen-CPUs

-

28 Augprozessor - cpu

Intel-Aktien könnten im Kampf mit TSMC und NVIDIA

-

28 Augprozessor - cpu

AMD soll gehackt worden sein

-

27 Augprozessor - cpu

Intel präsentiert Lunar Lake-, Xeon 6- und Guadi 3