Nvidias Blackwell wird eine teure Angelegenheit

.jpg)

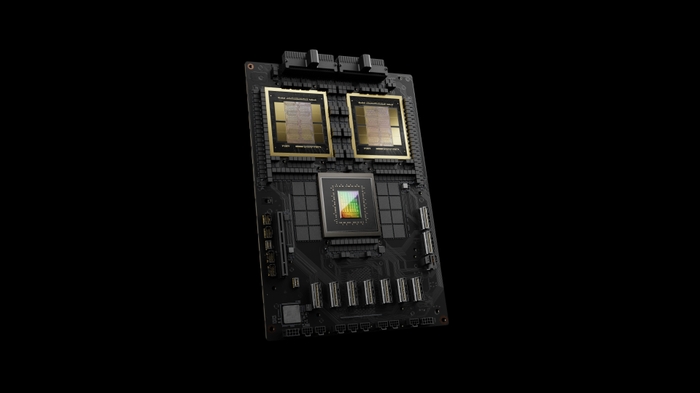

Laut Analysten von HSBC könnten Nvidias Blackwell-GPUs für KI-Anwendungen teurer sein als die Hopper-basierten Prozessoren des Unternehmens. Laut @firstadopter, einem leitenden Autor bei Barron's, kann ein einzelner GB200-Superchip (CPU+GPUs) bis zu 70.000 US-Dollar kosten. Allerdings ist Nvidia möglicherweise eher geneigt, Server auf Basis der Blackwell-GPUs zu verkaufen, anstatt Chips einzeln zu verkaufen, insbesondere wenn die B200 NVL72-Server voraussichtlich jeweils bis zu 3 Millionen US-Dollar kosten werden.

HSBC schätzt, dass Nvidias „Einstiegs“-GPU B100 einen durchschnittlichen Verkaufspreis zwischen 30.000 und 35.000 US-Dollar haben wird, was in der Preisspanne von Nvidias H100 liegt. Der leistungsstärkere GB200, der eine einzelne Grace-CPU mit zwei B200-GPUs kombiniert, wird voraussichtlich zwischen 60.000 und 70.000 US-Dollar kosten. Am Ende könnte es tatsächlich etwas mehr kosten, da es sich lediglich um Schätzungen von Analysten handelt.

Server, die auf Nvidias Design basieren, werden deutlich teurer sein. Die Nvidia GB200 NVL36 mit 36 GB200 Superchips könnte für durchschnittlich 1,8 Millionen US-Dollar verkauft werden, während die Nvidia GB200 NVL72 mit 72 GB200 Superchips den angeblichen HSBC-Zahlen zufolge rund 3 Millionen US-Dollar einbringen könnte. Als Nvidias CEO Jensen auf der diesjährigen GTC 2024 die Blackwell-Rechenzentrumschips vorstellte, war klar, dass es um den Umzug ganzer Server-Racks geht. Jensen hat wiederholt erklärt, dass er, wenn er an eine GPU denkt, jetzt das NVL72-Rack vor Augen hat.

Das gesamte Setup lässt sich über Verbindungen mit hoher Bandbreite integrieren, um als riesige GPU zu fungieren und insgesamt 13.824 GB VRAM bereitzustellen – ein entscheidender Faktor beim Training immer größerer LLMs. Durch den Verkauf ganzer Systeme anstelle einzelner GPUs/Superchips kann Nvidia einen Teil der von Systemintegratoren verdienten Prämie absorbieren, was den Umsatz und die Rentabilität des Unternehmens steigern wird. Da Nvidias Konkurrenten AMD und Intel mit ihren KI-Prozessoren langsam Fuß fassen, kann Nvidia seine KI-Prozessoren sicherlich mit einem enormen Aufschlag verkaufen.

Daher sind die angeblich von HSBC erstellten Preisschätzungen nicht besonders überraschend. Es ist auch wichtig, die Unterschiede zwischen dem H200 und dem GB200 hervorzuheben. Der H200 kostet für einzelne GPUs bereits bis zu 40.000 US-Dollar. Der GB200 wird effektiv die Anzahl der GPUs vervierfachen (vier Siliziumchips, zwei pro B200) und außerdem die CPU und die große Platine für den sogenannten Superchip hinzufügen. Die Rohberechnung für einen einzelnen GB200-Superchip beträgt 5 Petaflops FP16 (10 Petaflops mit Sparsity), verglichen mit 1/2 Petaflops (dicht/sparse) beim H200.

Das entspricht etwa fünfmal mehr Rechenaufwand, ohne Berücksichtigung anderer Architektur-Upgrades. Dabei ist zu bedenken, dass die tatsächlichen Preise für rechenzentrumstaugliche Hardware immer von den einzelnen Verträgen abhängig sind, basierend auf der Menge der bestellten Hardware und anderen Verhandlungen. Daher sind diese geschätzten Zahlen mit Vorsicht zu genießen. Größere Käufer wie Amazon und Microsoft dürften große Rabatte erhalten, während kleinere Kunden am Ende sogar noch höhere Preise zahlen könnten als von HSBC gemeldet.

Aktuelle prozessor - cpu

-

31 Oktprozessor - cpu

-

16 Sepprozessor - cpu

AMD Ryzen AI 7 PRO 360 entdeckt

-

04 Sepprozessor - cpu

Intel gewinnt großen KI-Chipkunden

-

04 Sepprozessor - cpu

Exklusiv von Intel hergestellte Ladenschubladen

-

29 Augprozessor - cpu

Großer Leistungsschub für Ryzen-CPUs

-

28 Augprozessor - cpu

Intel-Aktien könnten im Kampf mit TSMC und NVIDIA

-

28 Augprozessor - cpu

AMD soll gehackt worden sein

-

27 Augprozessor - cpu

Intel präsentiert Lunar Lake-, Xeon 6- und Guadi 3