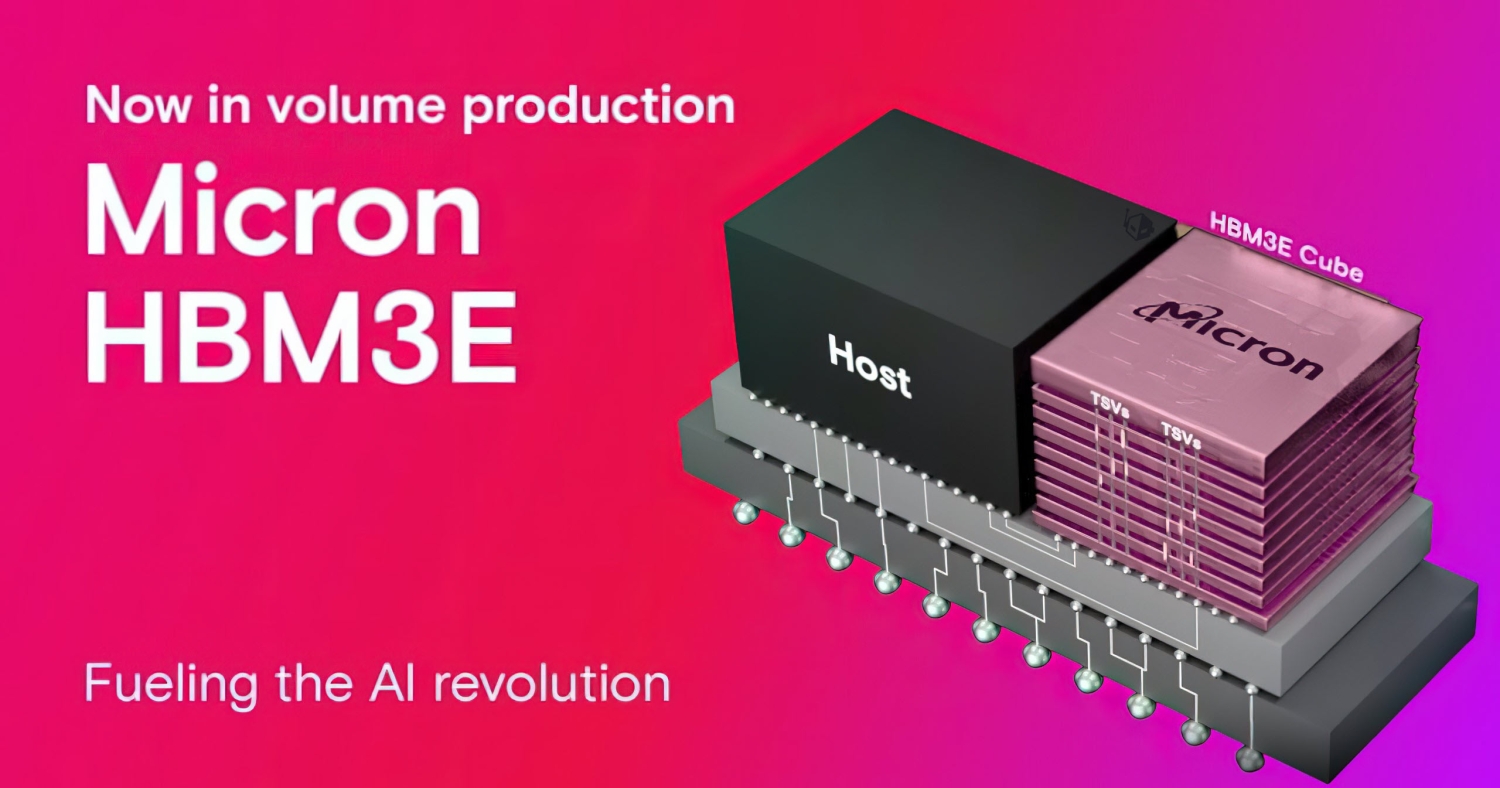

Micron HBM3E überrascht SK Hynix mit NVIDIA H200 AI GPU

Micron kündigte im Februar 2024 als erstes Unternehmen die Massenproduktion seines neuen ultraschnellen HBM3E-Speichers an und lag damit vor den HBM-Konkurrenten SK Hynix und Samsung. Das amerikanische Speicherunternehmen kündigte an, HBM3E-Speicherchips für NVIDIAs kommende H200 AI GPU zu liefern, die über HBM3E-Speicher verfügen wird, im Gegensatz zu ihrem Vorgänger mit der H100 AI GPU, die über HBM3-Speicher verfügte.

Micron wird seine neuen HBM3E-Speicherchips auf seinen 1-Milliarden-Nanometer-DRAM-Chips herstellen, vergleichbar mit den 12-nm-Knoten, die der HBM-Marktführer SK Hynix auf seinen HBM verwendet. Laut Korea JoongAng Daily ist Micron dem HBM-Konkurrenten Samsung „technisch voraus“, der immer noch die 1a-Nanometer-Technologie verwendet, was der 14-nm-Technologie entspricht.

Der neue 24-GB-8-Hi-HBM3E-Speicher von Micron wird das Herzstück der kommenden H200-KI-GPU von NVIDIA sein, und die Überlegenheit von Micron im HBM-Prozess ist ein wesentlicher Bestandteil des Vertrags mit NVIDIA. Micron erklärt seinen neuen HBM3E-Speicher:

- Überlegene Leistung: Mit Pin-Geschwindigkeit von über 9,2 Gigabit pro Sekunde (Gb/s) liefert Microns HBM3E mehr als 1,2 Terabyte pro Sekunde Sekunde (TB/s) Speicherbandbreite und ermöglicht so einen blitzschnellen Datenzugriff für KI-Beschleuniger, Supercomputer und Rechenzentren.

- Außergewöhnliche Effizienz: Der HBM3E ist branchenweit führend mit einem um etwa 30 % geringeren Stromverbrauch im Vergleich zu Konkurrenzangeboten. Um die wachsende Nachfrage und den Einsatz von KI zu unterstützen, bietet der HBM3E maximalen Durchsatz bei niedrigstem Stromverbrauch, um die wichtigsten wirtschaftlichen Kennzahlen des Rechenzentrumsbetriebs zu verbessern.

- Nahtlose Skalierbarkeit: Mit einer Kapazität von heute 24 GB ermöglicht der HBM3E Rechenzentren die nahtlose Skalierung ihrer KI-Anwendungen. Ganz gleich, ob es um das Training massiver neuronaler Netze oder die Beschleunigung von Inferenzaufgaben geht, die Lösung von Micron stellt die erforderliche Speicherbandbreite bereit.

Der Chipexperte Jeon In-seong und Autor von „The Future of the Semiconductor Empire“ sagte: „Es ist erwiesen, dass die Fertigungsmethode von Micron fortschrittlicher ist als die von Samsung Electronics, da ihr HBM3E mit 1b-Nanometer-Technologie hergestellt wird. Micron wird noch etwas Arbeit benötigen.“ auf Verpackungen, aber es sollte einfacher sein als das, was sie bereits mit der 1b-Nanometer-Technologie erreicht haben.“

Aktuelle ram

-

07 Augram

-

06 Augram

Samsung präsentiert dünnsten LPDDR5X DRAM

-

05 Augram

SK hynix konzentriert sich auf fortschrittliche HB

-

31 Julram

SK Hynix bringt 60 % schnelleres GDDR7 auf den Mar

-

28 Junram

SK Hynix beschleunigt HBM-Plan

-

17 Junram

KI steigert die lokale Chipnachfrage in China

-

17 Junram

Samsung startet 2024 den 3D-HBM-Chipdienst

-

16 Mairam

MSI und Patriot bringen Viper Gaming RAM auf den M